Chương trình Bảo vệ Tiền lương (PPP) được thực hiện bởi chính phủ liên bang Hoa Kỳ nhằm cung cấp động lực trực tiếp cho các doanh nghiệp để giữ nhân viên của họ trong biên chế, đặc biệt là trong đại dịch Covid-19. PPP hỗ trợ các doanh nghiệp đủ điều kiện duy trì lực lượng lao động của họ cũng như giúp thanh toán các chi phí kinh doanh liên quan. Dữ liệu từ trang web của Bộ Tài chính Hoa Kỳ cho thấy những công ty nào đã nhận được các khoản vay theo hình thức PPP và có bao nhiêu công việc được giữ lại. Bộ Tài chính Hoa Kỳ đã phê duyệt khoảng một triệu khoản vay PPP trên khắp Hoa Kỳ.

Phân tích dữ liệu này đưa ra ba thách thức. Đầu tiên, kích thước của dữ liệu là đáng kể. Khoảng thời gian để kéo, quản lý, chuyển đổi, truy xuất và báo cáo về dữ liệu đó là thời gian tiêu tốn nhiều thời gian. Thứ hai, tập dữ liệu có khả năng phát triển, điều này sẽ tiêu tốn thêm thời gian và tài nguyên phát triển. Cuối cùng, trong một quy trình gồm nhiều giai đoạn như thế này, rất có thể mọi thứ sẽ bị hỏng. Có khả năng nhanh chóng xác định lỗi hoặc tắc nghẽn sẽ giúp đáp ứng các SLA một cách nhất quán.

Blog này minh họa cách Cloudera Data Engineering (CDE), sử dụng Apache Spark, có thể được sử dụng để tạo báo cáo dựa trên dữ liệu PPP trong khi giải quyết từng thách thức được nêu ở trên.

Mục tiêu

Một kịch bản giả lập cho Ban Ngân sách Lập pháp Texas (LBB) được thiết lập bên dưới để giúp kỹ sư dữ liệu quản lý và phân tích dữ liệu PPP. Mục tiêu chính của kỹ sư dữ liệu này là cung cấp cho LBB hai báo cáo kết thúc:

- Báo cáo 1:Cơ cấu tất cả các thành phố ở Texas vẫn giữ được việc làm

- Báo cáo 2:Cơ cấu loại hình công ty đã giữ lại việc làm

Kỹ thuật dữ liệu Cloudera (CDE)

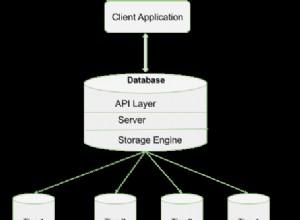

Đây là nơi Cloudera Data Engineering (CDE) đang chạy Apache Spark có thể trợ giúp. CDE là một trong những dịch vụ trong Nền tảng dữ liệu Cloudera (CDP) cho phép các kỹ sư dữ liệu tạo, quản lý và lên lịch công việc Apache Spark, đồng thời cung cấp các công cụ hữu ích để theo dõi hiệu suất công việc, truy cập tệp nhật ký và sắp xếp quy trình công việc thông qua Apache Airflow. Apache Spark là một khung xử lý dữ liệu có khả năng chạy nhanh quá trình xử lý dữ liệu quy mô lớn.

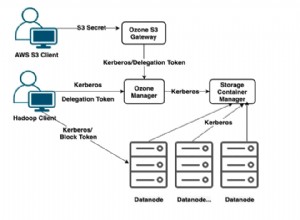

Bộ Tài chính Hoa Kỳ cung cấp hai bộ dữ liệu khác nhau, một bộ cho các khoản vay được phê duyệt lớn hơn 150 nghìn đô la và một bộ cho các khoản vay được phê duyệt dưới 150 nghìn đô la. Để tạo ra hai báo cáo kết thúc cho LBB, các bước sau được thực hiện (xem Hình 1).

- Bước đầu tiên là tải hai tập dữ liệu riêng biệt vào một nhóm S3.

- Một lệnh Spark đã được tạo cho mỗi tập dữ liệu để lấy và lọc dữ liệu từ nhóm S3.

- Hai công việc Spark này đã chuyển đổi và tải dữ liệu sạch vào kho dữ liệu Hive để truy xuất.

- Công việc Spark thứ ba đã được tạo để xử lý dữ liệu từ kho dữ liệu Hive để tạo hai báo cáo.

Khi công việc chạy hoàn tất, CDE cung cấp một biểu diễn đồ họa của các giai đoạn khác nhau trong mỗi công việc Spark (xem Hình 2). Điều này cho phép kỹ sư dữ liệu dễ dàng xem những phần nào của công việc có khả năng chiếm nhiều thời gian nhất, cho phép họ dễ dàng tinh chỉnh và cải thiện mã của mình để đáp ứng tốt nhất SLA của khách hàng.

Hình 1:Hành trình dữ liệu để tạo ra hai báo cáo kết thúc.

Hình 2:Biểu diễn đồ họa CDE của các giai đoạn Spark khác nhau.

Kết quả

Mục tiêu chính để tạo ra hai báo cáo kết thúc từ hồ sơ của một triệu ứng viên được chấp thuận đã được đáp ứng. Bản tóm tắt đồ họa của báo cáo đầu tiên (xem Hình 3) cho thấy 10 mẫu hàng đầu về số lượng việc làm được giữ lại trên mỗi thành phố ở Texas và báo cáo thứ hai (xem Hình 4) cho thấy 5 mẫu hàng đầu về số lượng việc làm được giữ lại theo loại hình công ty. Với những báo cáo này, Ban Ngân sách Lập pháp Texas, chẳng hạn, có thể suy luận rằng các thành phố có tỷ lệ duy trì việc làm trên đầu người ít nhất có thể cần các nguồn lực để giảm bớt bất kỳ tác động kinh tế nào.

Hình 3:10 thành phố hàng đầu giữ lại nhiều việc làm nhất, Bang Texas, 2020

Hình 4:5 loại công ty hàng đầu giữ được nhiều việc làm nhất, Bang Texas, 2020

Các bước tiếp theo

Để xem tất cả những điều này đang hoạt động, vui lòng nhấp vào các liên kết bên dưới đến một vài nguồn khác nhau giới thiệu quy trình đã được tạo ra.

- Video - Nếu bạn muốn xem và nghe cách xây dựng video này, hãy xem video tại liên kết.

- Hướng dẫn - Nếu bạn muốn thực hiện việc này theo tốc độ của riêng mình, hãy xem hướng dẫn chi tiết kèm theo ảnh chụp màn hình và hướng dẫn từng dòng về cách thiết lập và thực thi.

- Buổi gặp mặt - Nếu bạn muốn nói chuyện trực tiếp với các chuyên gia từ Cloudera, vui lòng tham gia buổi gặp mặt ảo để xem bản trình bày phát trực tiếp. Sẽ có thời gian cho phần Hỏi và Đáp trực tiếp khi kết thúc.

- Trang Người dùng CDP - Để tìm hiểu về các tài nguyên CDP khác được xây dựng cho người dùng, bao gồm video, hướng dẫn, blog và sự kiện bổ sung, hãy nhấp vào liên kết.